triển của công nghệ với các thông tin cứng (hard-information) để sản xuất các sản phẩm, dịch vụ với chi phí thấp tốt hơn các NHTM quy mô nhỏ. Điều này giúp lợi ích của thu nhập ngoài lãi mang lại đối với các NHTM quy mô lớn cao hơn các NHTM quy mô nhỏ. Vì vậy, giả thuyết 7.2 là tác động của tỷ lệ thu nhập ngoài lãi tới hiệu quả tài chính của NHTM tăng dần theo các cơ chế quy mô lớn dần.

Mô hình ngưỡng với biến thu nhập lãi cận biên và thu nhập ngoài lãi đồng thời thay đổi tác động

Trong trường hợp cho phép tỷ lệ lãi cận biên và tỷ lệ thu nhập ngoài lãi đồng thời thay đổi cấu trúc tác động theo các ngưỡng, hai biến này đóng vai trò các biến thay đổi tác động theo từng cơ chế (regime-dependent variable) được phân định bởi các ngưỡng, trong biến quy mô là biến ngưỡng. Mô hình ngưỡng trong trường hợp tồn tại hai ngưỡng (Mô hình 8) để trả lời Câu hỏi IX có dạng:

' '

X5 = *$+ ) *Yi 5 Z( 5 ≤ %) + ) *Yi 5 Z( %< 5 ≤ ')

Wi%

W' i.%

i'

i.%

Có thể bạn quan tâm!

-

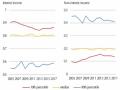

Tỷ Trọng Thu Nhập Từ Lãi Và Thu Nhập Ngoài Lãi Của Các Nhtm Thuộc Các Nhóm Phân Vị 10%, 90% Và Nhtm Tại Trung Vị (Median) Về Tổng Tài Sản

Tỷ Trọng Thu Nhập Từ Lãi Và Thu Nhập Ngoài Lãi Của Các Nhtm Thuộc Các Nhóm Phân Vị 10%, 90% Và Nhtm Tại Trung Vị (Median) Về Tổng Tài Sản -

Mô Hình Động Về Tác Động Của Các Nhân Tố Đến Hiệu Quả Tài Chính Các Ngân Hàng Thương Mại

Mô Hình Động Về Tác Động Của Các Nhân Tố Đến Hiệu Quả Tài Chính Các Ngân Hàng Thương Mại -

Các Giả Thuyết Về Sự Khác Biệt Trong Tác Động Đối Với Mô Hình 2:

Các Giả Thuyết Về Sự Khác Biệt Trong Tác Động Đối Với Mô Hình 2: -

Hiệu quả theo quy mô của các ngân hàng thương mại Việt Nam - 12

Hiệu quả theo quy mô của các ngân hàng thương mại Việt Nam - 12 -

Tình Hình Kinh Tế Vĩ Mô Và Hiệu Quả Tài Chính Của Các Ngân Hàng Thương Mại Tại Việt Nam

Tình Hình Kinh Tế Vĩ Mô Và Hiệu Quả Tài Chính Của Các Ngân Hàng Thương Mại Tại Việt Nam -

Kết Quả Ước Lượng Mô Hình Động Về Tác Động Của Các Nhân Tố Tới Hiệu Quả Tài Chính Của Các Ngân Hàng Thương Mại

Kết Quả Ước Lượng Mô Hình Động Về Tác Động Của Các Nhân Tố Tới Hiệu Quả Tài Chính Của Các Ngân Hàng Thương Mại

Xem toàn bộ 248 trang tài liệu này.

P -

W+ ) *Y Z(

< ) + ) * , + ) * ^

+ + /

(MH 8 . 1)

W

Wi.%

W

i2 i 5

'

' 5

;

;.%

; 5

'

3 35 5

3.%

W5 = *$+ ) *Yi 5 Z( 5 ≤ %) + ) *Yi 5 Z( %< 5 ≤ ')

i%

W i.%

W '

i.%

P

i'

'$%R

i2

W+ ) *Yi 5 Z( '< 5 ) + ) *;,; 5 + ) *5O. cdJ5+ + /5 (MH 8 . 2)

Vi.%

;.%

5.'$%$

Trong đó: Mô hình 8.1 (MH 8.1) và Mô hình 8.2 (MH 8.2) lần lượt đại điện cho lựa chọn 1 và 2 đối với Mô hình 8.

Biến phụ thuộc Yitlà ROA hoặc ROE của các NHTM tại mỗi năm. Các chỉ số i, t đại diện cho các đơn vị chéo và năm; là thành phần không quan sát được, không biến đổi theo thời gian, thể hiện đặc điểm nội tại của NHTM; /5 là sai số đặc trưng của mô hình. U(.) là hàm chỉ thị nhị phân, nhận giá trị bằng 1 nếu biểu thức trong ngoặc thỏa mãn và bằng 0 nếu không thỏa mãn. %và 'lần lượt là giá trị các ngưỡng (%< ').

i 5 đại diện cho hai biến NIM, DIA (các biến đồng thời thay đổi thay đổi tác động theo mỗi cơ chế). ,; 5 đại diện cho các biến độc lập về đặc điểm NHTM (S, CA, LDR, LPCLR, OEAR) trong khi đó, ^35 đại diện cho các biến về nhân tố ngành và kinh tế vĩ mô (CON, MSG, GDPG, INF), O. cdJ5 đại diện cho các biến giả năm, trừ năm cơ sở (2009).

Giả thuyết đặt ra đối với Câu hỏi IX theo mô hình 8 là:

Giả thuyết 8.1: Mô hình 8 tồn tại ngưỡng quy mô, tại đó, tác động của thu nhập lãi cận biên và tỷ lệ thu nhập ngoài lãi đến hiệu quả tài chính đồng thời thay đổi.

Giả thuyết 8.2: Sự gia tăng trong tác động của DIA tới hiệu quả tài chính ngày càng lớn hơn so với sự gia tăng trong tác động của NIM theo các cơ chế quy mô ngày càng lớn dần. Căn cứ giải thích của De Young và Roland (2001), các NHTM có quy mô càng lớn, càng thu được nhiều lợi nhuận hơn khi tăng đòn bẩy hoạt động (DOL) khi chúng tận dụng sự phát triển của công nghệ để thúc đẩy bán các sản phẩm ngoài lãi dựa trên quy mô lớn hơn về thông tin cứng (hard information) nhằm giảm chi phí biến đổi cận biên, và DOL không có giới hạn bởi các quy định hiện hành, trong khi việc gia tăng DFL sẽ gặp phải giới hạn bởi các quy định an toàn vốn. Vì vậy, khi quy mô càng lớn, quá trình gia tăng tỷ lệ DOL/DFL sẽ giúp NHTM tăng dần hiệu quả tài chính, đồng thời tránh được các quy định giới hạn về an toàn vốn. Trong quá trình này, tác động tới hiệu quả tài chính của thu nhập ngoài lãi cận biên ngày càng tăng tương đối so với thu nhập lãi cận biên.

2.5. Phương pháp ước lượng dữ liệu bảng

2.5.1. Các phương pháp ước lượng mô hình dữ liệu bảng tĩnh (static panel data)

Trong hồi quy dữ liệu bảng, các phương pháp ước lượng tĩnh được nhiều nghiên cứu sử dụng là hồi quy OLS gộp (Pooled OLS – POLS), Tác động cố định cố định (FEM), tác động ngẫu nhiên (REM), bình phương tối thiểu tổng quát khả thi (FGLS)

Phương pháp hồi quy OLS gộp (pooled OLS): đây là phương pháp ước lượng hồi quy tuyến tính thông thường áp dụng cho dữ liệu. Đặc điểm của phương pháp này là nó không tính đến sự không đồng nhất giữa các đối tượng trong mẫu cũng như những sự thay đổi qua thời gian của các đối tượng. POLS xem xét các quan sát trong dữ liệu bảng một cách độc lập như các quan sát trong chéo. Nếu mô hình thỏa mãn các giả thuyết của hồi quy tuyến tính cổ điển như không có hiện tượng đa cộng tuyến hoàn hảo, không xảy ra tự tương quan, không có phương sai sai số thay đổi thì ước lượng POLS là không chệch và vững tốt nhất trong lớp các ước lượng tuyến tính không chệch hay còn gọi là ước lượng BLUE (best linear unbiased efficiency).

Phương pháp hồi quy với tác động cố định (fixed effect method – FEM): trong trường hợp mẫu quan sát bao gồm nhân tố thuộc bản chất của mỗi đối tượng và không biến đổi theo thời gian (ai), ai có tương quan với các biến giải thích trong mô hình, và nhân tố này không được đưa vào mô hình được ước lượng bằng POLS, tức nó nằm

trong thành phần sai số thì xảy ra hiện tượng nội sinh trong mô hình, kết quả ước lượng bằng POLS bị chệch và không vững. Để giải quyết vấn đề này, trong phương pháp FE, người ta tách thành phần ai khỏi sai số ngẫu nhiên, thành phần còn lại của sai số là εit được gọi là sai số đặc trưng của mô hình (idiosyncratic error term). Mục đích việc tách là để εit không còn tương quan với các biến giải thích trong mô hình và tránh hiện tượng nội sinh. Nếu mô hình được ước lượng bằng FEM không xảy ra các hiện tượng đa cộng tuyến hoàn hảo, tự tương quan và phương sai sai số không đổi thì ước lượng FEM thu được là vững và hiệu quả.

Phương pháp hồi quy với tác động ngẫu nhiên (random effect method – REM): Trong trường hợp thành phần ai không tương quan với các biến giải thích thì ước lượng POLS là vững, tuy nhiên POLS có thể xảy ra hiện tượng phương sai sai số thay đổi. Khi đó người ta sử dụng phương pháp Hồi quy tuyến tính tổng quát (GLS) để khắc phục và thay thế cho POLS. Phương pháp REM là việc sử dụng ước lượng GLS (generalized least squares) cho mẫu nhằm thu được ước lượng hiệu quả trong trường hợp xảy ra hiện tượng phương sai sai số thay đổi.

Phương pháp bình phương tối thiểu tổng quát khả thi (feasible generalized least squares- FGLS): Phương pháp này thường được sử dụng trong các trường hợp mô hình có hiện tượng phương sai số thay đổi hoặc tự tương quan. Để các ước lượng thu được từ FGLS hiệu quả và vững, mẫu quan sát cần lớn. Trong trường hợp này, FGLS đạt hiệu quả cao hơn và là phương pháp thay thế tốt cho OLS.

2.5.2. Phương pháp Moment tổng quát (GMM) cho mô hình dữ liệu bảng

động (dynamic panel data)

Trong nhiều chủ đề nghiên cứu, việc đánh giá tác động của các nhân tố trong quá khứ đến giá trị hiện tại thể hiện qua các mô hình động rất quan trọng. Nó không chỉ nhằm mục đích giải quyết vấn đề động về mặt lý thuyết. Về mặt kỹ thuật, việc kiểm soát các giá trị quá khứ trong mô hình nghiên cứu giúp mô hình giải thích tốt hơn sự thay đổi của biến phụ thuộc, tránh rủi ro thiếu biến nghiêm trọng hoặc nội sinh do biến trễ nằm trong thành phần sai số có thể tương quan với các biến độc lập khác. Trong nhiều nghiên cứu, việc sử dụng các giá trị trễ tại nhiều cấp độ của chính biến phụ thuộc để giải thích là một phương án hiệu quả, nó đại diện cho tác động tổng hợp của các nhân tố trong quá khứ đến biến phụ thuộc trong kỳ hiện tại. Tuy nhiên, việc thêm biến trễ của biến phụ thuộc (ví dụ: Yt-1) vào mô hình vẫn không giải quyết được hoàn toàn rủi ro nội sinh, nếu nó tương quan với sai số gộp của mô hình, lúc này mô hình thường được biết đến với tên gọi mô hình dữ liệu bảng động chệch (dynamic

panel bias) (Nickell, 1981). Điều này dẫn đến việc các ước lượng như POLS, REM, FEM có thể bị chệch. Để giải quyết hiện tượng nội sinh, có thể áp dụng các phương pháp sử dụng biến công cụ (instrument variable –IV). Tuy nhiên không phải lúc nào cũng có thể tìm được IV phù hợp và ngoại sinh chặt (strictly exogenous) cho mô hình. Để giải quyết đồng thời các vấn đề trên, L.P Hansen13 (1982) đề xuất phương pháp Ước lượng Moment tổng quát (generalized method of moments) cho phép ước lượng

các mô hình có hiện tượng nội sinh và over-identification trong nhiều trường hợp. Ước lượng thu được từ GMM là vững, tức là nếu thỏa mãn một số điều kiện nhất định, nó hội tụ về giá trị trung bình tổng thể khi cỡ mẫu tiến về vô hạn (Hansen,1982), đồng thời cũng xử lý được các khuyết tật như phương sai sai số thay đổi hay tự tương quan.

Arellano & Bond (1991) kết hợp phép biến đổi cùng nhóm (within-group transformation) và phương pháp GMM của Hansen để tạo thành GMM sai phân (difference GMM). Tuy nhiên GMM sai phân có một số các nhược điểm như:

(i) GMM sai phân chỉ sử dụng các điều kiện moment (moment conditions) cho phương trình sai phân trở nên thiếu hiệu quả khi mẫu nghiên cứu có số kỳ (T) ngắn.

(ii) GMM sai phân thiếu hiệu quả trong trường hợp biến phụ thuộc là một biến gần với một bước ngẫu nhiên (random walk), khi đó các giá trị trễ của biến gốc không phản ánh nhiều thông tin về sự thay đổi trong tương lai. Nói cách khác, các trễ của biến gốc (untransformed lags) là biến công cụ yếu đối với các biến sai phân (transformed Variables).

(iii) Tổng quát hơn (ii), GMM sai phân thiếu hiệu quả trong trường hợp biến công cụ sử dụng là yếu (weak instrument), tức là mối tương quan giữa nó và các biến nội sinh trong mô hình thấp.

(iv) GMM sai phân cũng thiếu hiệu quả trong trường hợp mẫu nghiên cứu là dữ liệu bảng không cân bằng (unbalanced panel data).

(v) GMM sai phân sử dụng phép biến đổi cùng nhóm (within-group transformation), tương tự cách biến đổi của FEM nên nó loại trừ các biến độc lập không biến đổi theo thời gian (time invariant) khỏi mô hình (ví dụ: các biến giả phân nhóm không đổi theo thời gian).

Để cải thiện kết quả ước lượng từ GMM sai phân, Arellano và Bover (1995) và Blundell và Bond (1998) tiếp tục phát triển GMM sai phân thành GMM hệ thống (system GMM) thông qua việc ước lượng hệ phương trình kết hợp phương trình sai phân (difference equation) từ GMM sai phân và phương trình ở dạng gốc (levels

13 Giải Nobel kinh tế học năm 2013, trong đó GMM là một trong những đóng góp quan trọng của ông.

equation), đồng thời sử dụng các giá trị trễ của biến gốc và biến sai phân của các biến độc lập trong mô hình làm biến công cụ. Độ chính xác của ước lượng từ GMM hệ thống được kiểm tra thông qua mô phỏng Monte Carlo (Blundell và Bond, 1998; Bond và cộng sự, 2001; Hayakawa, 2007; Soto, 2009) đều chính xác (chệch ít) hơn GMM sai phân, sự cải thiện càng rõ rệt trong trường hợp số kỳ quan sát ngắn. Hayakawa (2007) cho thấy GMM hệ thống luôn chệch ít hơn GMM sai phân, dù cho nó sử dụng nhiều biến công cụ hơn. Nguyên nhân chính là do cả hai thành phần gây chệch trong ước lượng GMM hệ thống được đo bằng: (i) Tổng (có trọng số) của chệch trong các ước lượng tại phương trình sai phân (first-differencing) và phương trình gốc (level- estimator) và (ii) Chệch do việc sử dụng đồng thời hệ phương trình, đều được giảm thiểu do chệch tại phương trình sai phân và chệch tại phương trình gốc có chiều hướng đối lập nhau và chúng sẽ loại trừ nhau khi kết hợp thành hai thành phần (i) và (ii). Bên cạnh đó, so với GMM sai phân, GMM hệ thống bao gồm thêm các điều kiện moment khác từ việc bổ sung phương trình dạng gốc cho phép áp dụng tốt với các loại dữ liệu bảng có T ngắn, bảng không cân bằng (unbalanced panel data), cho phép ước lượng các biến không thay đổi theo thời gian, và xử lý tốt hơn trong trường hợp biến công cụ yếu cũng như nhiều trường hợp khác.

Bên cạnh việc phân loại GMM sai phân và GMM hệ thống, mỗi loại GMM trên đều có thể gồm hai phiên bản: GMM một bước (one step) và GMM hai bước (two step). Điểm khác biệt chính nằm ở ma trận hiệp phương sai của sai số chuẩn. GMM một bước sử dụng ma trận hiệp phương sai thuần nhất (homogenous), trong khi GMM hai bước sử dụng ma trận hiệp phương sai không thuần nhất (heterogenous). Điều này giúp GMM hai bước tự nó đã khắc phục được hiện tượng phương sai sai số thay đổi, trong khi với GMM hệ thống một bước cần khắc phục bằng sai số chuẩn cải thiện thông thường. Nhìn chung, ước lượng thu được từ GMM hai bước hiệu quả hơn GMM một bước (Blundell và Bond, 1998), tuy nhiên các kết quả mô phỏng Monte Carlo cho thấy sự chênh lệch này không lớn (Blundell và Bond, 1998; Bond và cộng sự, 2001; Soto, 2009). Dù vậy, tốc độ hội tụ về phân phối tiệm cận trong trường hợp GMM hai bước lại chậm hơn và sai số chuẩn tiệm cận của GMM hai bước bị chệch xuống nhiều (seriously biased downwards) với mẫu hữu hạn (finite sample), do đó nó không đáng tin cậy cho suy diễn thống kê, trong khi đó, sai số chuẩn tiệm cận trong GMM một bước hầu như không chệch (Windmeijer, 2005). Vì lẽ đó, Bond và cộng sự (2001), Roodman (2009) và Soto (2009) đều khuyến nghị sử dụng GMM hệ thống một bước, với sai số chuẩn cải thiện (robust) không chỉ có phân phối tiệm cận vững, khắc phục được phương sai sai số thay đổi mà còn đáng tin cậy hơn GMM hệ thống hai bước khi

suy diễn thống kê. Để khắc phục hiện tượng chệch xuống nghiêm trọng trong sai số chuẩn của GMM hai bước, Windmeijer (2005) đã đưa ra giải pháp sai số chuẩn cải thiện của mình, điều này đã giúp GMM hệ thống hai bước đạt được hiệu quả cao trong nghiên cứu thực nghiệm. Nghiên cứu này theo đó sẽ lựa chọn GMM hệ thống hai bước (twostep system GMM) cùng hiệu chỉnh sai số chuẩn theo Windmeijer (2005) để thu được kết quả ước lượng chính xác hơn GMM hệ thống một bước và khắc phục được các khuyết tật phương sai sai số thay đổi, tự tương quan và nội sinh (nếu có).

Để nhìn nhận một cách rõ ràng hơn việc cân nhắc sử dụng ước lượng GMM hệ thống từ cỡ mẫu, cần lưu ý một điều kiện để thực hiện một cách hiệu quả ước lượng GMM cho dữ liệu bảng đó là số lượng đơn vị chéo (individuals) N cần lớn tương đối (về số lần) so với số lượng kỳ quan sát (T), do đó có cơ sở để đánh giá rằng mẫu nghiên cứu này với số đơn vị chéo N=30 và số kỳ T=9 chỉ thuộc phân khúc đạt yêu cầu tối thiểu điều kiện về cỡ mẫu để có thể áp dụng GMM hệ thống (vốn sản sinh ra nhiều biến công cụ hơn GMM sai phân) một cách hiệu quả. Thật vậy, các yêu cầu cần kiểm định để ước lượng GMM đạt hiệu quả gồm:

(i) Số lượng biến công cụ (IV) được sinh ra từ GMM không được vượt quá số đơn vị chéo (individuals) trong mẫu. Điều này được biết đến như là việc tuân thủ nguyên tắc ngón tay cái (rule of thumb) theo Roodman (2009).

(ii) Số lượng đơn vị chéo (N) cần lớn, trong khi số kỳ (T) nhỏ. Không có tiêu chuẩn chính xác về khái niệm lớn, nhỏ, tuy nhiên khó có thể áp dụng GMM một cách hiệu quả với mẫu có khoảng 20 đơn vị chéo (Roodman, 2009). Roodman nhận định chung cho việc áp dụng GMM trong khi GMM hệ thống nhìn chung đòi hỏi nhiều đơn vị chéo hơn GMM sai phân (với cùng mẫu dữ liệu) vì nó sản sinh nhiều biến công cụ hơn (kết hợp mục (i)). Soto (2009) tập trung hơn vào việc áp dụng các phiên bản GMM cho cỡ mẫu nhỏ. Tác giả giảm dần tỷ lệ N/T từ giá trị 100/05 xuống 50/12 và thấp nhất là 35/12. Trong trường hợp ứng lệ thấp nhất là 35/12 xấp xỉ 3 lần, số lượng biến công cụ theo ước lượng GMM đã bắt đầu vượt quá N hoặc gần bằng N (nếu sử dụng giải pháp nhằm hạn chế số lượng biến công cụ). Bên cạnh đó, Pop và cộng sự (2018) cũng loại trừ khả năng sử dụng GMM để kiểm vững cho nghiên cứu vì mẫu nghiên cứu chỉ có 33 NHTM, trong khi số kỳ là 10 năm từ 2007 đến 2016, tỷ lệ N/T=3,3. Luận án này do đó lấy mốc N/T=3 làm giá trị tối thiểu cho việc áp dụng GMM và phương pháp biến công cụ nói chung đối với dữ liệu bảng trong nghiên cứu thực nghiệm.

Với mẫu thực tế có N=30 và T=09 năm (tỷ lệ N/T = 30/9 ~ 3,33 >3), nghiên cứu sử dụng ước lượng GMM. Tuy nhiên nếu chia tách mẫu làm tỷ lệ này nhỏ hơn 3,

nghiên cứu sẽ lựa chọn phương pháp khác thay thế GMM và các phương pháp biến công cụ.

(iii) Ước lượng từ GMM thường sinh ra nhiều IV. Nhìn chung, số lượng IV sinh ra càng nhiều, ước lượng càng chệch (Winmeijer, 2005; Roodman, 2009). Một mặt, số lượng IV cần đảm bảo thỏa mãn (i), tuy nhiên một vấn đề bắt đầu nảy sinh từ khi IV vượt quá số lượng biến độc lập nội sinh trong mô hình nghiên cứu. Hiện tượng này (over-identification) là điều kiện cần thiết để kiểm định việc IV có tương quan với thành phần sai số trong mô hình hay không14, trong trường hợp này kiểm định Wald về tính đồng thời ngoại sinh của các IV (joint validity) khó khả thi. Tuy vậy, Hansen

(1982) kế thừa Sargan (1958) và phát triển từ kiểm định Wald đã xây dựng kiểm định Hansen/Sargan (J-Test) về sự giới hạn định dạng quá mức (overidentifying restriction) cho phép kiểm tra tính ngoại sinh đồng thời của các IV trong ước lượng GMM với giả thuyết H0: các biến công cụ sử dụng đồng thời ngoại sinh chặt, tức không tương quan với sai số. Giá trị P-value của kiểm định Hansen/Sargan vì vậy càng lớn càng tốt và không được thấp hơn 10% (Roodman, 2009). Cũng lưu ý số lượng IV được sinh ra gia tăng nhanh chóng với số kỳ T, và việc có nhiều IV làm yếu kiểm định Hansen, do vậy nghiên cứu này khi sử dụng lệnh xtabond2 ước lượng GMM hệ thống sẽ sử dụng tùy chọn “collapse” để hạn chế sự gia tăng của IV, đảm bảo số lượng IV < N và đảm bảo kiểm định Hansen có hiệu lực.

(iv) Để uớc lượng GMM đạt hiệu quả, việc không tồn tại tự tương quan hay tương quan chuỗi (serial correlation) trong thành phần sai số là điều kiện cần thiết. Nếu có hiện tượng tương quan chuỗi bậc một ở sai số (dạng gốc) thì trễ bậc hai của biến phụ thuộc (Yi,t-2) sẽ có tương quan với trễ bậc một của sai số (dạng gốc) và cho thấy các biến công cụ sau đó là không phù hợp. Theo Arellano và Bond (1991) việc kiểm định tương quan chuỗi bậc k của sai số ở dạng gốc (level) tương đương với việc kiểm định tương quan chuỗi bậc k+1 của sai số ở dạng sai phân (difference). Về mặt toán học, thành phần sai số ở dạng sai phân mặc nhiên có tự tương quan bậc một15, nên việc kiểm định tương quan chuỗi bậc hai của sai số ở dạng sai phân sẽ được sử dụng để kiểm định cho hiện tượng tự tương quan bậc một của sai số ở dạng gốc, lưu ý thực

chất lúc này là kiểm định cho sự tương quan của trễ bậc nhất và trễ bậc hai của sai số (dạng gốc) thông qua kiểm định tương quan giữa sai số hiện tại (dạng sai phân) với trễ bậc hai của nó. Kiểm định AR(1) lúc này có thể bỏ qua, thay vào đó kiểm định AR(2)

14 Mô hình dù định dạng đủ (Just-identification) cũng không thể kiểm định được, bởi vì muốn kiểm định sự ngoại sinh của một biến thuộc vế phải của mô hình (dù là biến độc lập trong mô hình hay biến công cụ), cần thêm tối thiểu một biến công cụ cho biến đó.

15 Vì khi ở dạng sai phân, sai số và trễ bậc nhất của nó đều chứa thành phần trung gian là sai số (dạng gốc) ở trễ bậc nhất.

với giả thuyết H0: Không tồn tại tự tương quan bậc hai trong thành phần sai số (dạng sai phân) sẽ được sử dụng. Vì vậy, giá trị P-value của kiểm định AR(2) trong nghiên cứu thực nghiệm cần lớn hơn 10% để ước lượng GMM là hiệu quả.

2.5.3. Phương pháp hồi quy ngưỡng dữ liệu bảng (Panel Threshold Regression)

Để đánh giá tác động không đồng nhất (Heterogeneity effect) giữa từng nhóm dữ liệu trong mẫu, các nghiên cứu có thể sử dụng các phương pháp như sử dụng biến giả (dummy) cho các nhóm và kiểm soát thành phần tương tác giữa biến giả với biến giải thích trọng tâm là biến liên tục, phân tích tác động khác biệt trong khác biệt (difference in difference), hồi quy phân vị (quantile regression). Đặc điểm chung của các phương pháp này là việc các nhóm dữ liệu đã được xác định trước, sau đó các kỹ thuật trên sẽ giúp ước lượng các mối quan hệ theo từng nhóm. Phương pháp hồi quy ngưỡng dữ liệu bảng (panel threshold regression – PTR) được đề xuất bởi B.E Hansen (1999) áp dụng cho dữ liệu bảng cân bằng (balanced panel), ưu điểm của phương pháp PTR so với các phương pháp trên là nó cho phép khai phá các mối quan hệ phi tuyến theo các ngưỡng (threshold) hay điểm gãy cấu trúc (structual breakpoint) (Wang và Shao, 2019) hay sự thay đổi cấu trúc (structural changes) (Djatche, 2018) chưa xác định trước của mô hình ngưỡng. PTR đã được nhiều nghiên cứu trên thế giới sử dụng để khai phá các mối quan hệ phi tuyến và hiệu ứng ngưỡng trong nhiều lĩnh vực khác nhau, ví dụ như:

Trong lĩnh vực kinh tế môi trường, Ouyang và cộng sự (2019) cho thấy mối quan hệ hình chữ U đảo ngược (inverted U-shape) giữa mức độ đô thị hóa (tỷ lệ % dân cư thành thị trên tổng dân cư) và mức độ ô nhiễm. Wang và Shao (2019) phát hiện hiệu ứng ngưỡng trong tác động của quy định về môi trường lên tăng trưởng xanh đại diện bởi chỉ số Malmquist Luenberger. Mối quan hệ giữa tốc độ đô thị hóa và lượng khí thải nhà kính cũng được phân tích nhiều gần đây như Cao Zi và cộng sự (2016) và Du và Xia (2018). Du và Xia (2018) cho thấy tác động dương của đô thị hóa lên lượng khí thải nhà kính, tuy nhiên khi khi tốc độ đô thị hóa vượt ngưỡng 23,59% hoặc lượng khí thải nhà kính vượt 42.287 tấn CO2, tác động này được tăng cường. Bên cạnh đó, ý nghĩa thống kê của tác động này cũng sẽ mạnh hơn nếu tỷ lệ dân cư của các đại đô thị (trên 1 triệu dân) chiếm trên 20,01% tổng dân cư của quốc gia hoặc nếu thành phố đông dân nhất chiếm trên 48,27% tổng dân cư thành thị.

Đối với khu vực tài chính, PTR được sử dụng nhiều để tìm các ngưỡng thay đổi tác động hoặc mức tối ưu hóa của tỷ lệ lạm phát lên tăng trưởng kinh tế hay cấu trúc vốn tối ưu theo Lý thuyết cấu trúc vốn của Modigliani và Miller. Brana và Prat